DeepSeek联合清华大学提出通过改进奖励模型生成机制的推理时扩展新方法

发布时间:2025-04-234月4日,DeepSeek与清华大学的研究团队发布一种名为“自我原则批评调整(SPCT)”的新方法,该研究通过改进奖励模型(RM)的生成机制,解决了传统强化学习在跨领域奖励信号获取上的局限性。

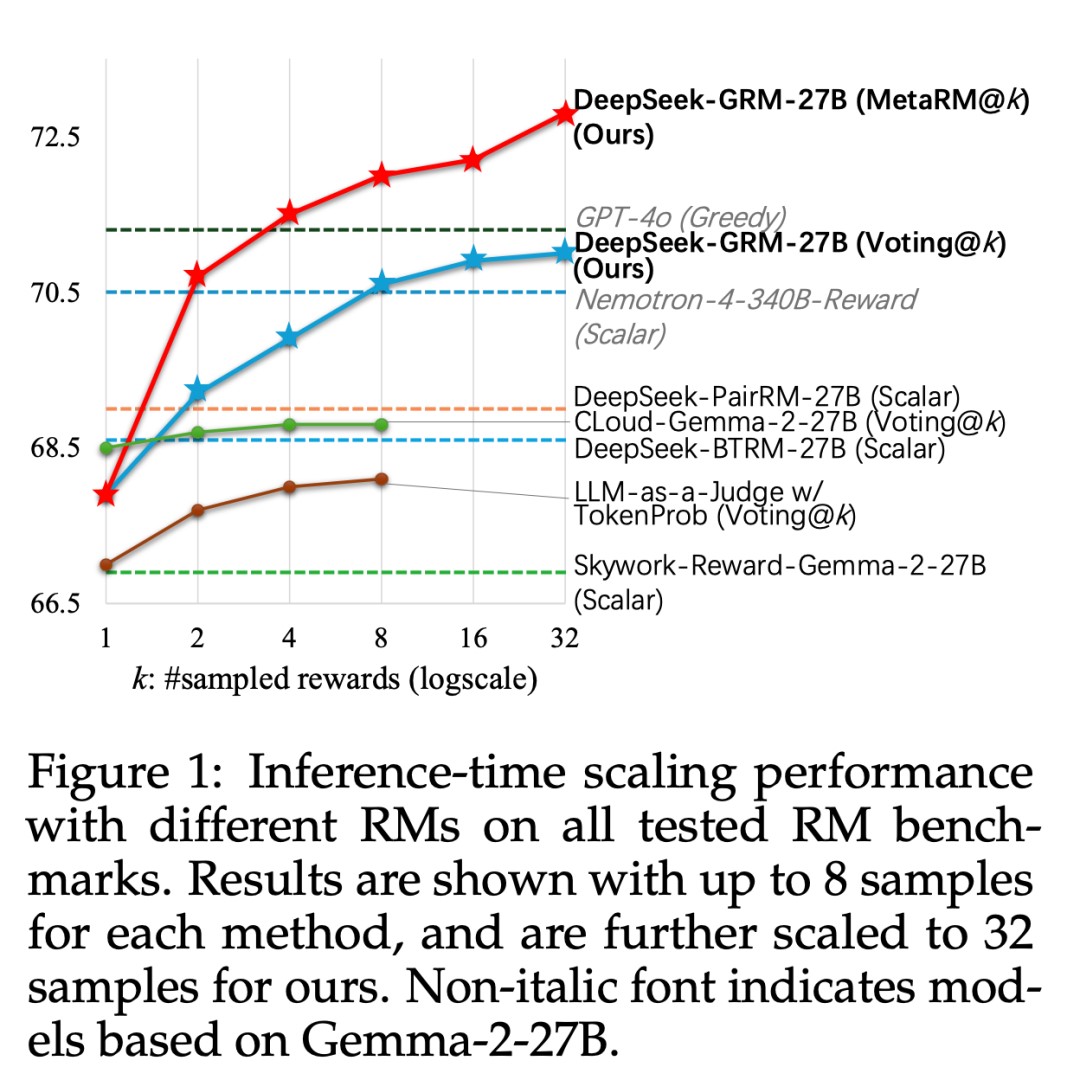

团队基于Gemma-2-27B模型训练出DeepSeek-GRM-27B,并引入元奖励模型(Meta RM)进一步提升推理性能,在多项基准测试中超越现有方法。

研究核心在于通过SPCT框架实现推理时的动态扩展。该方法分为两阶段:冷启动阶段采用拒绝式微调(RFT)确保原则和批评的生成质量;第二阶段通过基于规则的在线强化学习,使模型能自适应生成高质量原则并细化奖励评分。实验表明,DeepSeek-GRM-27B在32次采样扩展下,性能优于参数量达671B的更大模型,且无显著领域偏差。这一成果为LLM的通用奖励系统提供了新思路,未来或推动模型训练与推理效率的进一步突破。

来源:阿尔法公社