k1.5 新模型登场:Kimi 如何做到满血版多模态o1水平(附技术报告)

发布时间:2025-01-221月20日, Kimi发布的全新SOTA模型 ——k1.5 多模态思考模型。这是继去年 11 月发布 k0-math 数学模型、12月发布 k1 视觉思考模型之后,连续第三个月带来 k 系列强化学习模型的重磅升级。

一、k1.5多模态思考模型

K1.5性能方面,实现了 SOTA级别的多模态推理和通用推理能力。

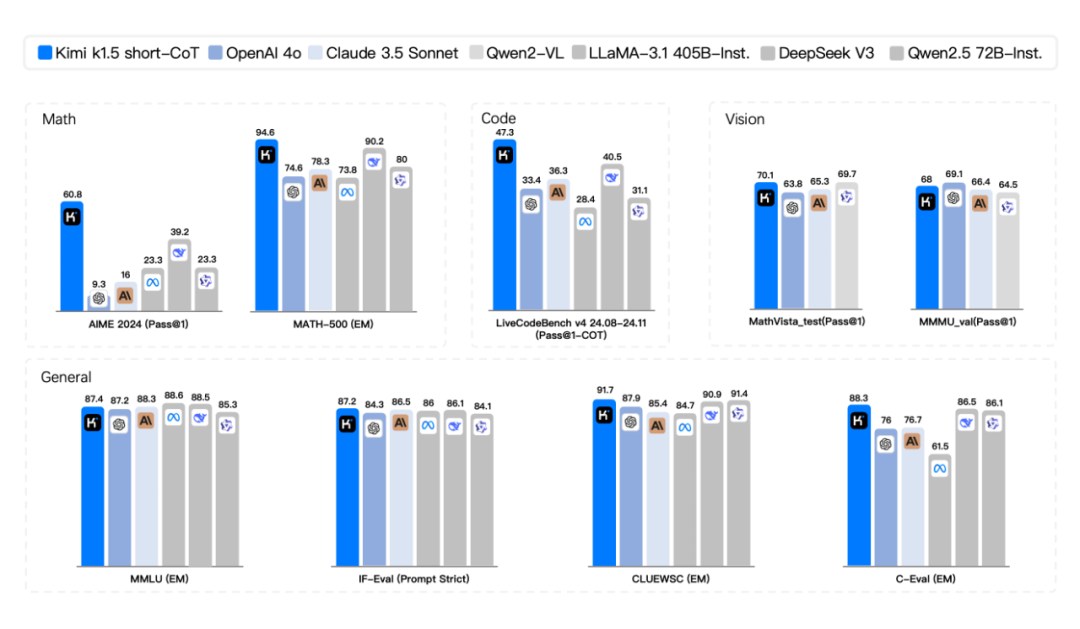

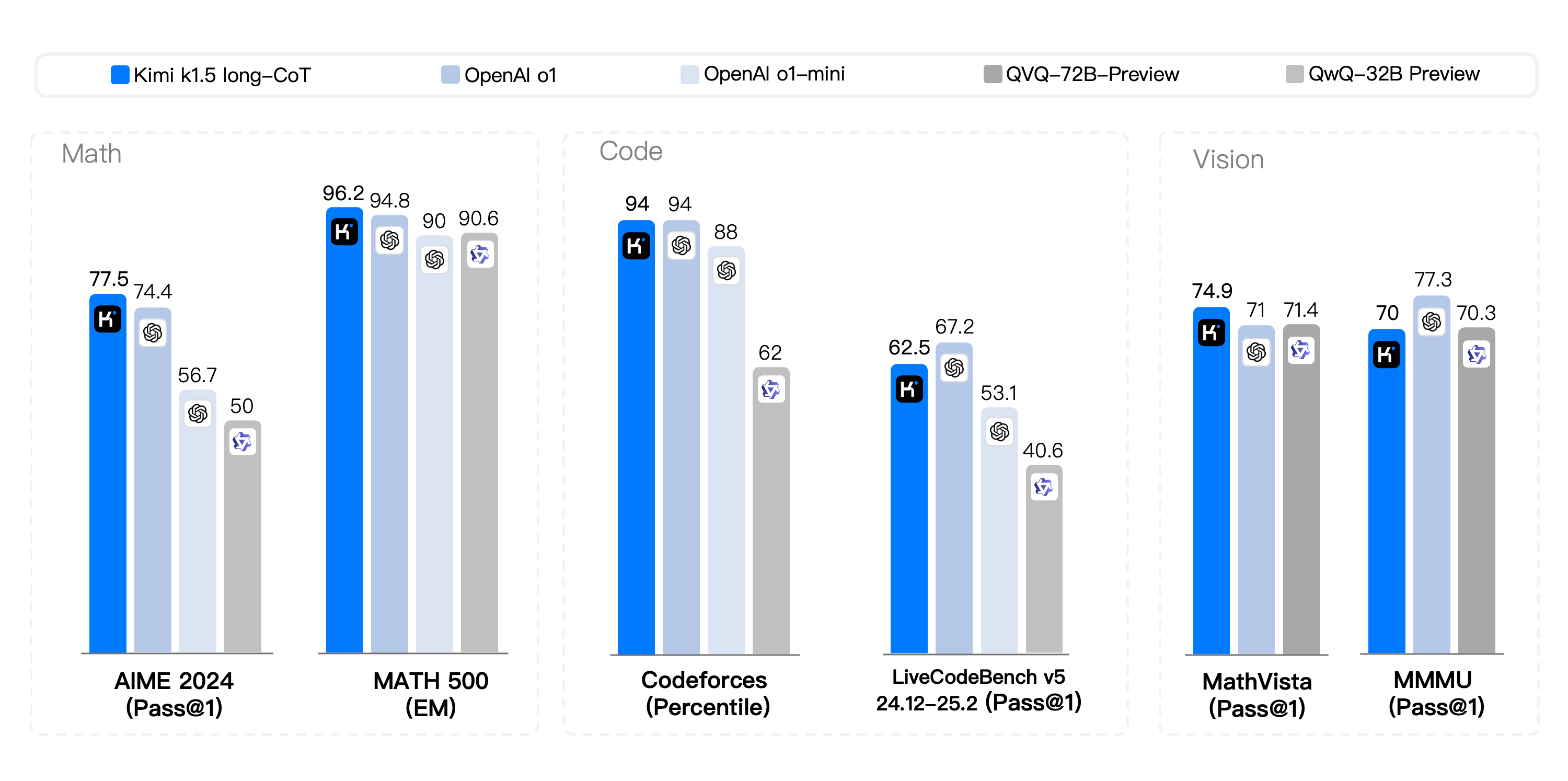

具体来说,在 short - CoT 模式下,k1.5 的数学、代码、视觉多模态和通用能力大幅超越 GPT - 4o 和 Claude 3.5 Sonnet 等短思考 SOTA 模型,领先达 550%。在 long-CoT 模式下,Kimi k1.5 的数学、代码、多模态推理能力,也达到长思考 SOTA 模型 OpenAI o1 正式版的水平。这应该是全球范围内,OpenAI 之外的公司首次实现 o1 正式版的多模态推理性能。

二、SOTA模型是如何训练出来的

Kimi 技术团队同步发布了模型训练技术报告,记录和分享新技术范式下的模型训练技术探索之路。

技术报告:Kimi k1.5:借助大语言模型实现强化学习的 Scaling

从技术报告来看,k1.5 模型设计和训练的几个关键要素:

长上下文扩展。将 RL 的上下文窗口扩展到 128k,随着上下文长度的增加,性能持续提升。该方法的关键思想是,使用部分展开(partial rollouts)来提高训练效率——即通过重用大量先前的轨迹来采样新的轨迹,避免了从头开始重新生成新轨迹的成本。技术团队观察表明,上下文长度是通过 LLMs 持续扩展RL的一个关键维度。

改进的策略优化。推导出了long-CoT的 RL 公式,并采用在线镜像下降的变体进行稳健的策略优化。该算法通过有效采样策略、长度惩罚和数据配方的优化进一步得到改进。

简洁的框架。长上下文扩展与改进的策略优化方法相结合,为通过LLMs学习建立了一个简洁的RL框架。由于能够扩展上下文长度,学习到的 CoTs 表现出规划、反思和修正的特性。增加上下文长度的效果是增加了搜索步骤的数量。因此,可以在不依赖更复杂技术(如蒙特卡洛树搜索、价值函数和过程奖励模型)的情况下实现强大的性能。

多模态能力。该模型在文本和视觉数据上联合训练,具有联合推理两种模态的能力,数学能力出众,但由于主要支持LaTeX等格式的文本输入,依赖图形理解能力的部分几何图形题则难以应对。

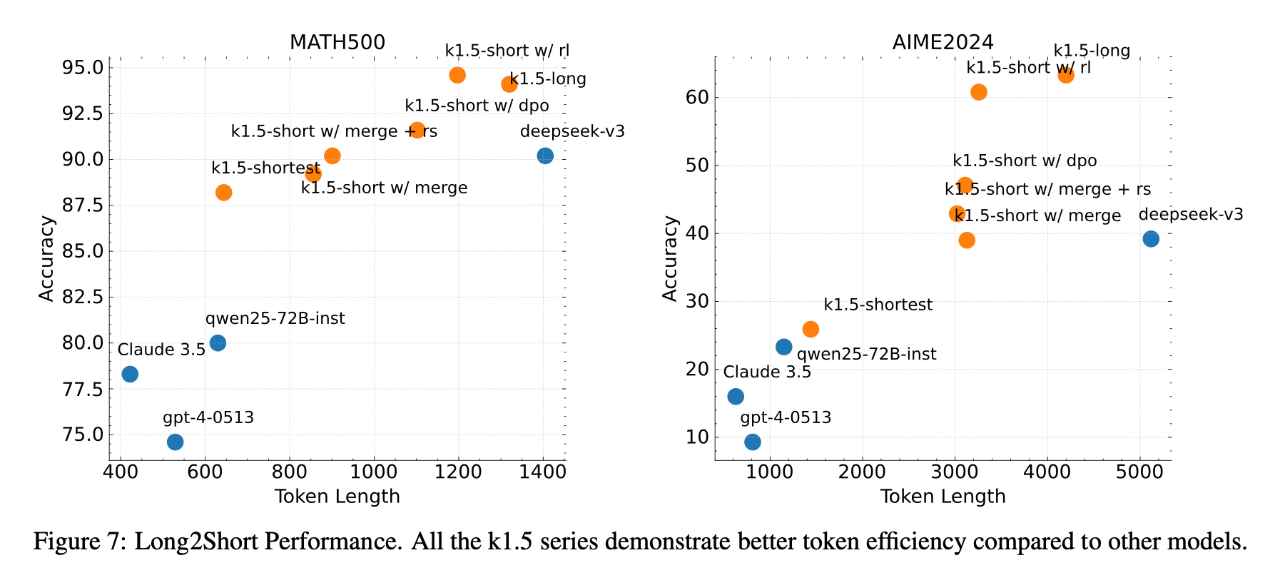

此外,他们提出了有效的long2short方法,利用 Long-CoT 技术来改进 Short-CoT 模型,在短链思维推理方面取得了SOTA成绩——例如,在AIME上达到60.8分,MATH500上达到94.6分,LiveCodeBench上达到47.3分——大幅超越了现有的短链思维模型,如GPT-4和Claude Sonnet 3.5(提升幅度高达550%)。

k1.5 多模态思考模型预览版将陆续灰度上线 Kimi.com 网站和最新版本的 Kimi 智能助手 app,用户看到模型切换按钮即可试用。

2025 年,他们会继续升级 k 系列强化学习模型,提升多模态、多领域及通用能力。

https://mp.weixin.qq.com/s/BmOKGKjXP2tjmPyNdU0Hqg

来源:月之暗面Kimi