阿里达摩院发布首个大规模中文多模态评测基准MUGE

发布时间:2022-01-19在计算机视觉领域甚至人工智能的发展历程中,ImageNet对于整个领域的技术进步具有至关重要的作用。随着多模态学习成为当下的新热点,为了通过大规模数据集建设和全方位模型能力评测推动多模态领域的发展,阿里达摩院推出MUGE(全称Multimodal Understanding and Generation Evaluation Benchmark)评测基准。

该基准是由达摩院联合浙江大学、阿里云天池平台联合发布,中国计算机学会计算机视觉专委会(CCF-CV专委)协助推出的首个大规模中文多模态评测基准。其拥有全球最大规模的中文多模态评测数据集,覆盖多种类型的任务,包括图文描述、基于文本的图像生成、跨模态检索等。

MUGE的推出旨在解决当前中文多模态领域下游任务数据集匮乏的问题,并且为广大研究者提供权威平台,从理解能力和生成能力两大角度去衡量算法模型的有效性。

背景

近年来,大规模神经网络模型以及预训练等技术的成功实践推动着计算机视觉和自然语言处理等领域快速发展,同时也推动了多模态表征学习的研究。2020 年 Jeff Dean 就曾指出,多模态研究将会是未来研究一大趋势。

在国内,目前阿里巴巴达摩院智能计算实验室也在深度探索中文多模态预训练及超大规模预训练,近期相继推出了百亿、千亿、万亿参数和十万亿参数模型 M6 模型 [1][2][3][4],目前是全球规模最大的预训练模型,并已将其应用到各大下游任务,广泛落地到搜索、推荐、服饰设计、智能文案等真实场景中。同时,达摩院联合阿里云发布了 M6 预训练平台(https://m6.aliyun.com),将大模型的能力以服务的形式对外提供,同时 M6 预训练平台是目前下游任务覆盖最广泛的平台,简洁易用,数行代码即可执行微调和预测等功能。

然而,目前多模态领域的评测基准和数据集多以英文为主,如 MSCOCO 的 Image Captioning [5],VQA [6][7],textVQA,VCR 等,并且缺乏一个统一的评测基准让研究人员可以全面评测自己的模型在不同场景以及不同任务类型的表现。当前中文领域的多模态公开数据集和榜单更是乏善可陈。考虑到中文多模态领域的蓬勃发展,达摩院智能计算实验室认知智能团队推出了大规模中文多模态评测基准 MUGE,拥有当前最大规模的中文多模态评测数据集,覆盖多种类型的任务,包括图文描述、基于文本的图像生成、跨模态检索等,对模型展开了全方位的评测,帮助研究人员对自己的模型得到更好的理解。

MUGE 介绍

MUGE 全称是 Multimodal Understanding and Generation Evaluation Benchmark,是达摩院联合浙江大学、阿里云天池平台共同发布的多模态数据集,中国计算机学会计算机视觉专委会协助,旨在推动多模态领域的发展,尤其预训练和下游任务应用等。首期主要开放中文多模态相关下游任务数据集和评测榜单,旨在帮助中文多模态研究人员全方位评估算法模型。MUGE 将实现多场景多任务的覆盖,其中包括理解类任务,如跨模态检索、跨模态分类等,以及生成类任务,如图文描述、基于文本的图像生成等,研究人员能够从理解能力和生成能力两大角度去评估算法模型。首期开放了包括了如下 3 个任务:

E-Commerce IC(Image Caption)

图像描述生成是一项经典的多模态任务,任务目标是根据一张图像生成相应的文字描述,要求生成的描述须如实反映图中的物体以及关键细节。电商领域有着众多的商品图片,将图像描述技术应用于电商领域,为每个商品生成一段富含吸引力的描述,对于吸引用户的点击、提高转化率有着重要的意义。

本次发布 E-Commerce IC 数据集涵盖了服装、食品、化妆品、3C 数码配件等众多商品类目,所有数据均来源于真实的淘宝电商场景。其中,商品对应的文字描述由商家根据商品特性来撰写,不同文案间的风格差异很大,这给图像描述的生成带来了很多挑战。E-Commerce IC 共包含 5w 条训练数据和 5k 条验证集数据,同时提供 1w 张图片用于在线评测,是目前业界最大的中文电商 Caption 数据集。

下面是两个样例:

例子 1:

l 输入(商品图片):

l 输出(商品文案描述):使用原始北欧风格,崇尚自然,以木色、黑色、白色作为整体色调,给人舒适宁静的感觉,轻松就餐,才能留住好食光,在极简风的北欧餐厅中,尽情享受美食。

例子 2:

l 输入(商品图片):

l 输出(商品文案描述):西装印花裙的两件套,知性中又有带着优雅洒脱。雅致的印花裙邂逅西服,轻松打造精致的职场女神。脱掉外套依然美丽优雅,不失为明智的穿搭。V 领的设计更显女性的性感魅力。如行走的时装画册精致,有品位更具有风度。

E-Commerce T2I(Text to Image):

文本到图像生成是一项具有挑战性的任务,要求模型具有在跨模态理解的基础上生成图像的能力。任务目标是根据一段文本描述,生成符合相应描述的图像,同时要求图像清晰且逼真。电商领域有着众多的商品图片,将文本到图像生成技术应用于电商领域,对于商品上新、设计、分发,减少商家运营成本,提高用户体验有着重要的意义。

本次发布的 ECommerce-T2I 数据集涵盖了服装、饰品、化妆品内的多个商品类目,所有数据均来源于真实淘宝电商场景。整个数据集由训练集、验证集和测试集组成。其中训练集有 9w 张图片,验证集和测试集各有 5k 张。此外,本数据集内的图片均为白底图,选手无需额外的精力放在背景生成上,主要考查模型对商品文本的理解和生成能力,提高物体的生成质量。

下面是两个样例:

例子一:

l 输入(文本):绵羊毛商务休闲西服套装

l 输出(生成图像):

例子二:

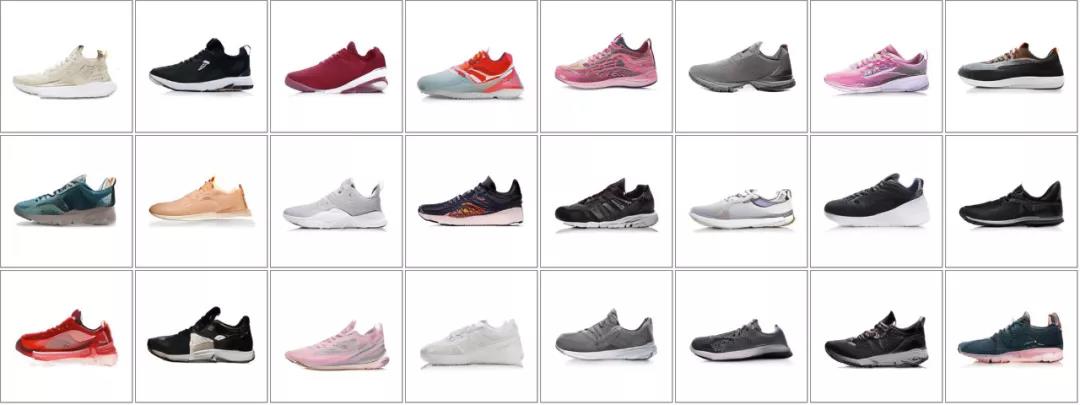

l 输入(文本):减震透气跑鞋

l 输出(生成图像):

Multimodal Retrieval Dataset

多模态检索评价模型进行图文理解和匹配的能力,是电商场景中满足用户需求、促成点击交易不可缺少的一环。在此次任务中,我们准备了来自于淘宝电商平台的真实搜索 query 及商品图,要求模型从给定的商品池中检索出与搜索 query 相匹配的商品(样例如下图)。为了更好评价模型跨模态理解的效果,我们此次不公开商品的标题以及其他信息,要求模型仅基于商品图片进行检索召回,具有一定的挑战性。

此次公开的电商图文检索数据集由训练集、验证集和测试集组成,其中训练集包含 25w 搜索 query - 商品图构成的图文对,涵盖约 12w 商品图片。对于验证集和测试集,我们各准备了 5k 搜索 query 和 3w 候选商品图片。数据集类目涵盖广泛,涉及服装、家居、电子、化妆品等多个领域,是目前最大的中文全领域电商图文检索数据集,对模型的泛化能力提出了考验。

下面是两个样例:

例子 1:

l 输入(Query):纯棉碎花吊带裙

l 输出:商品图片

例子 2:

l 输入(Query):北欧轻奢边几

l 输出:商品图片

MUGE 挑战榜

MUGE 的提出旨在解决当前中文多模态领域下游任务数据集匮乏的问题,并且为广大研究者提供平台和评测基准去衡量算法模型的有效性。此外,相较于传统榜单,MUGE 的覆盖面更全,涵盖理解和生成两大类任务,并开创性地将基于文本的图像生成纳入其中。未来,MUGE 也会持续地扩增更多的多模态任务及数据规模,进一步为研究人员和开发者提升算法模型效果而提供支持。

MUGE 目前已经在阿里云天池平台开放,感兴趣的研究者们可以访问如下链接进入 MUGE leaderboard 参与挑战,平台会在每个月的月底评出榜单 Top8 选手,并赠予天池定制礼品!

MUGE 挑战榜地址:https://tianchi.aliyun.com/muge

参考资料

[1] Lin, J., Men, R., Yang, A., Zhou, C., Ding, M., Zhang, Y., Wang, P., Wang, A., Jiang, L., Jia, X., Zhang, J., Zhang, J., Zou, X., Li, Z., Deng, X., Liu, J., Xue, J., Zhou H., Ma, J., Yu, J., Li, Y., Zhou, J., Tang, J., & Yang, H. (2021). M6: A chinese multimodal pretrainer. Proceedings of the 27th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining.

[2] Yang, A., Lin, J., Men, R., Zhou, C., Jiang, L., Jia, X., Wang, A., Zhang, J., Wang, J., Li, Y., Zhang, D., Lin, W., Qu, L., Zhou, J., & Yang, H. (2021). M6-T: Exploring Sparse Expert Models and Beyond. ArXiv, abs/2105.15082.

[3] Lin, J., Yang, A., Bai, J., Zhou, C., Jiang, L., Jia, X., ... & Yang, H. (2021). M6-10T: A Sharing-Delinking Paradigm for Efficient Multi-Trillion Parameter Pretraining. arXiv preprint arXiv:2110.03888.

[4] Zhang, Z., Ma, J., Zhou, C., Men, R., Li, Z., Ding, M., ... & Yang, H. (2021). M6-ufc: Unifying multi-modal controls for conditional image synthesis. NeurIPS 2021.

[5] Chen, X., Fang, H., Lin, T., Vedantam, R., Gupta, S., Dollár, P., & Zitnick, C.L. (2015). Microsoft COCO Captions: Data Collection and Evaluation Server. ArXiv, abs/1504.00325

[6] Agrawal, A., Lu, J., Antol, S., Mitchell, M., Zitnick, C.L., Parikh, D., & Batra, D. (2015). VQA: Visual Question Answering. International Journal of Computer Vision, 123, 4-31.

[7] Goyal, Y., Khot, T., Summers-Stay, D., Batra, D., & Parikh, D. (2017). Making the V in VQA Matter: Elevating the Role of Image Understanding in Visual Question Answering. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 6325-6334.

来源:机器之心